大語言模型技術發展與演進 軟硬件協同創新的雙輪驅動

大語言模型(Large Language Model, LLM)作為當前人工智能領域的皇冠明珠,其迅猛發展與演進,從根本上說是計算機軟件與硬件技術深度協同、螺旋式驅動的結果。從最初的統計語言模型到如今的千億、萬億參數規模,每一次質的飛躍都離不開底層計算架構、算法設計和工程實現的合力突破。

硬件基石:算力解放與架構革新

大語言模型發展的首要驅動力是計算硬件的持續演進。

- GPU與并行計算的崛起:傳統CPU的串行處理模式難以應對神經網絡龐大的矩陣運算。以NVIDIA GPU為代表的并行計算架構,憑借其海量核心(CUDA Core/Tensor Core)和高帶寬內存,成為訓練LLM的絕對主力。其大規模并行處理能力,使得訓練過去不可想象的超大規模模型成為可能。

- 專用AI芯片的涌現:為更極致地優化LLM訓練與推理,谷歌的TPU、華為的昇騰、Graphcore的IPU等專用AI處理器應運而生。它們在芯片層面針對矩陣乘加、非線性激活等核心操作進行定制化設計,擁有更高的計算密度和能效比,進一步壓低了訓練成本與時間。

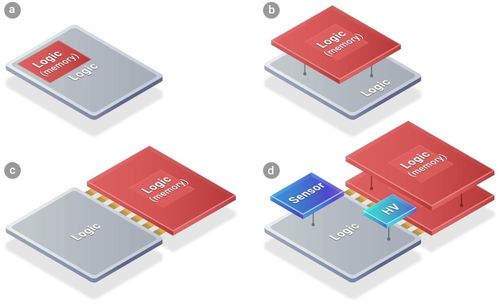

- 內存與互聯技術的突破:LLM的參數規模動輒數百GB,遠超單個處理器內存容量。高帶寬內存(HBM)、NVLink/NVSwitch高速互聯技術,以及分布式訓練框架,使得成千上萬個計算節點能夠高效協同,如同一個巨型虛擬處理器,共同承載和運算整個模型。

軟件靈魂:算法創新與系統優化

在硬件提供的算力舞臺上,軟件技術的創新則譜寫了LLM能力的核心樂章。

- 模型架構的演進:從早期的RNN、LSTM處理序列數據的瓶頸,到Transformer架構的橫空出世,其自注意力機制完美解決了長距離依賴問題,成為當今所有主流LLM的基石。GPT系列的自回歸生成架構、T5的統一文本到文本框架、MoE(混合專家)模型等,都在此基礎上不斷優化模型效率與能力邊界。

- 訓練方法與算法的精進:

- 規模化定律(Scaling Laws):OpenAI等機構提出的縮放規律,為“大力出奇跡”提供了理論指導,明確了模型規模、數據量和計算量之間的量化關系。

- 高效的優化器與訓練技巧:如AdamW優化器、學習率預熱與衰減策略、梯度裁剪、混合精度訓練等,極大地提升了訓練穩定性和速度。

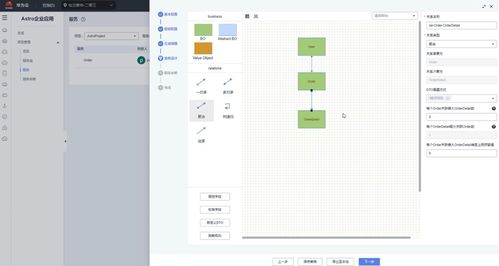

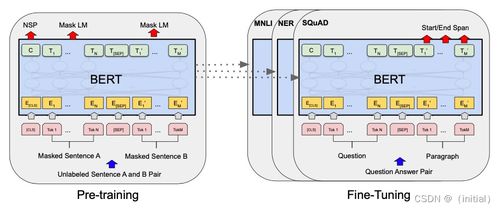

- 預訓練-微調范式:在海量無標注文本上預訓練獲得通用語言理解與生成能力,再針對特定任務進行有監督微調(SFT),這一范式成為構建實用LLM應用的標準流程。

- 推理與服務系統的工程優化:模型訓練完成后的部署是另一大挑戰。模型壓縮(如量化、剪枝、知識蒸餾)、動態批處理、持續批處理(Continuous Batching)、張量并行、流水線并行等推理優化技術,以及Triton Inference Server、vLLM等高性能推理引擎,使得百億參數模型也能以較低的延遲服務海量用戶請求。

軟硬件協同:螺旋上升的演進路徑

LLM技術的發展絕非軟硬件的簡單疊加,而是深度的協同設計與閉環反饋:

- 硬件定義軟件可能:新一代GPU/TPU的Tensor Core直接針對Transformer的注意力機制進行優化,促使算法團隊設計更充分利用該硬件的模型變體。

- 軟件驅動硬件革新:LLM對顯存帶寬和容量的極致需求,反向推動HBM等內存技術的快速迭代;對低延遲推理的要求,催生了邊緣AI芯片的發展。

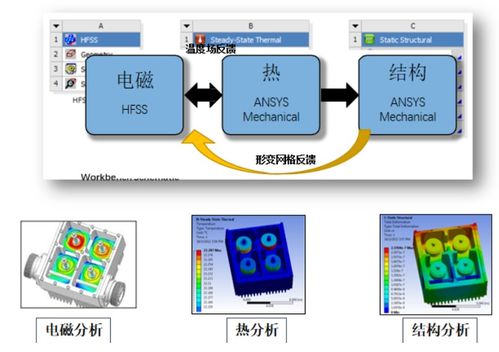

- 系統級協同優化:從PyTorch、TensorFlow等深度學習框架與CUDA的深度綁定,到Megatron-LM、DeepSpeed等分布式訓練庫對硬件集群拓撲的智能感知與調度,軟硬件在系統層面已融為一體。

未來展望:面向更高效、更通用的智能

大語言模型的演進將繼續在軟硬件協同的軌道上深化:

- 硬件層面:下一代芯片將更注重訓練與推理的能效比,存算一體、光計算等新型計算范式可能打破“內存墻”限制。面向Agent(智能體)持續交互的硬件支持將更受關注。

- 軟件與算法層面:模型架構將繼續追求“更聰明而非更龐大”,如更高效注意力機制、更優的稀疏化模型。訓練過程將更注重數據質量、多模態融合以及對齊人類價值觀(RLHF、DPO等)。推理端將追求極致的成本與延遲優化。

- 協同層面:從芯片到框架再到模型算法的全棧垂直優化將成為核心競爭力。軟硬件協同設計(Co-design)將更加普遍,可能出現專門為某類革命性模型架構定制的超級計算系統。

大語言模型波瀾壯闊的發展史,是一部計算機軟硬件技術交織并進、相互成就的史詩。算力硬件的每一次躍遷都為模型規模的擴張打開新空間,而算法軟件的每一次創新又對底層硬件提出新要求并挖掘其潛能。這場軟硬共舞的雙輪驅動,正以前所未有的速度,推動著通用人工智能(AGI)的輪廓日益清晰。

如若轉載,請注明出處:http://www.hnzzmjd.cn/product/37.html

更新時間:2026-01-19 07:45:51